LakeFlow

Erfassen, transformieren und orchestrieren – mit einer durchgängigen Data-Engineering-Lösung

TOP-UNTERNEHMEN, DIE LAKEFLOW NUTZENDie End-to-End-Lösung für die Bereitstellung hochwertiger Daten

Tools, die es jedem Team erleichtern, zuverlässige Datenpipelines für Analytik und KI zu bauen.85% schnellere Entwicklung

50% Kostenreduktion

99 % Reduzierung der Pipeline-Latenz

2.500 Jobläufe täglich

Corning verwendet Lakeflow, um die Datenorchestrierung zu vereinfachen und einen automatisierten, wiederholbaren Prozess für mehrere Teams in der gesamten Organisation zu schaffen. Diese automatisierten Workflows bewegen riesige Datenmengen durch eine Medaillon-Architektur von Bronze- zu Goldtabellen.

Konsolidierte Tools für Data Engineers

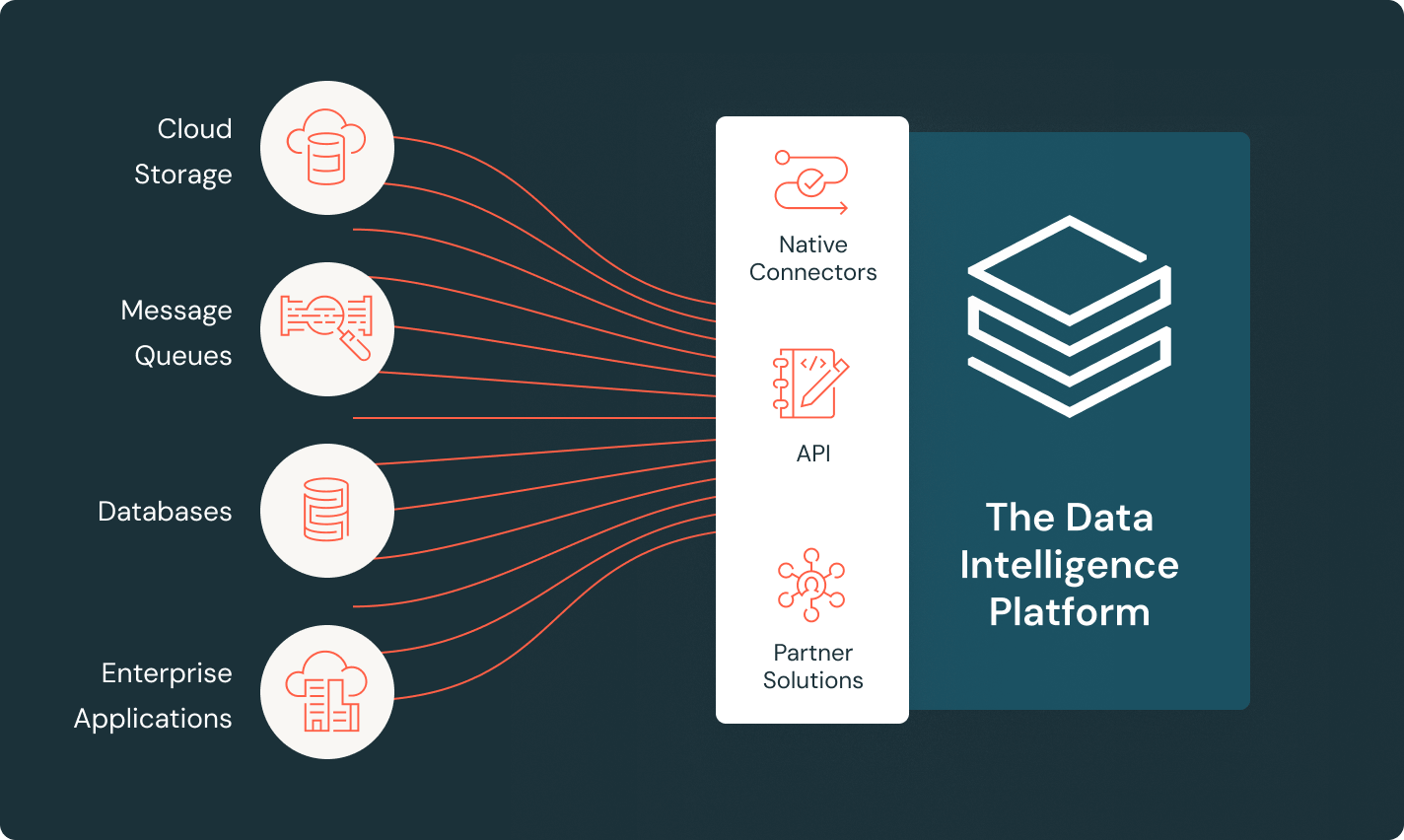

LakeFlow Connect

Effiziente Konnektoren für die Datenaufnahme und native Integration mit der Data Intelligence Platform erschließen einen einfachen Zugang zu Analytik und KI mit einheitlicher Governance.

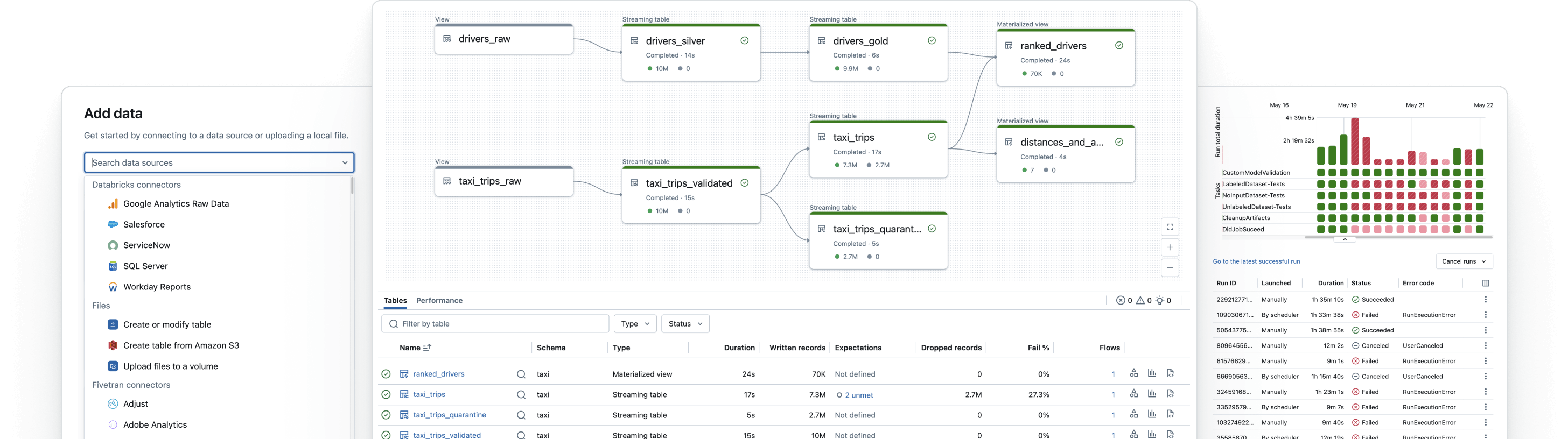

Lakeflow Deklarative Pipelines

Vereinfachen Sie Batch- und Streaming-ETL mit automatisierter Datenqualität, Change Data Capture (CDC), Datenaufnahme, Transformation und einheitlicher Governance.

Lakeflow Jobs

Statten Sie Teams besser aus, um jeden ETL-, Analyse- und KI-Workflow mit tiefer Observability, hoher Zuverlässigkeit und breiter Unterstützung für verschiedene Aufgaben zu automatisieren und zu orchestrieren.

Unity Catalog

Regulieren Sie alle Ihre Datenressourcen nahtlos mit der branchenweit einzigen einheitlichen und offenen Governance-Lösung für Daten und KI, die in die Data Intelligence Platform von Databricks integriert ist.

Lakehouse-Speicherung

Vereinheitlichen Sie die Daten in Ihrem Lakehouse format- und typenübergreifend für alle Ihre Analytics- und KI-Workloads.

Data Intelligence Platform

Entdecken Sie die gesamte Bandbreite der auf der Databricks Data Intelligence Platform verfügbaren Tools zur nahtlosen Integration von Daten und KI in Ihrem Unternehmen.

Erstellen Sie zuverlässige Datenpipelines

Nutzen Sie den Wert Ihrer Daten, egal wo sie sich befinden

Bringen Sie alle Ihre Daten mit den Lakeflow-Konnektoren für Dateiquellen, Unternehmensanwendungen und Datenbanken in die Data Intelligence Plattform. Vollständig verwaltete Konnektoren, die inkrementelle Datenverarbeitung nutzen, sorgen für eine effiziente Datenaufnahme und die integrierte Governance ermöglicht die volle Kontrolle über Ihre Daten entlang der gesamten Pipeline.

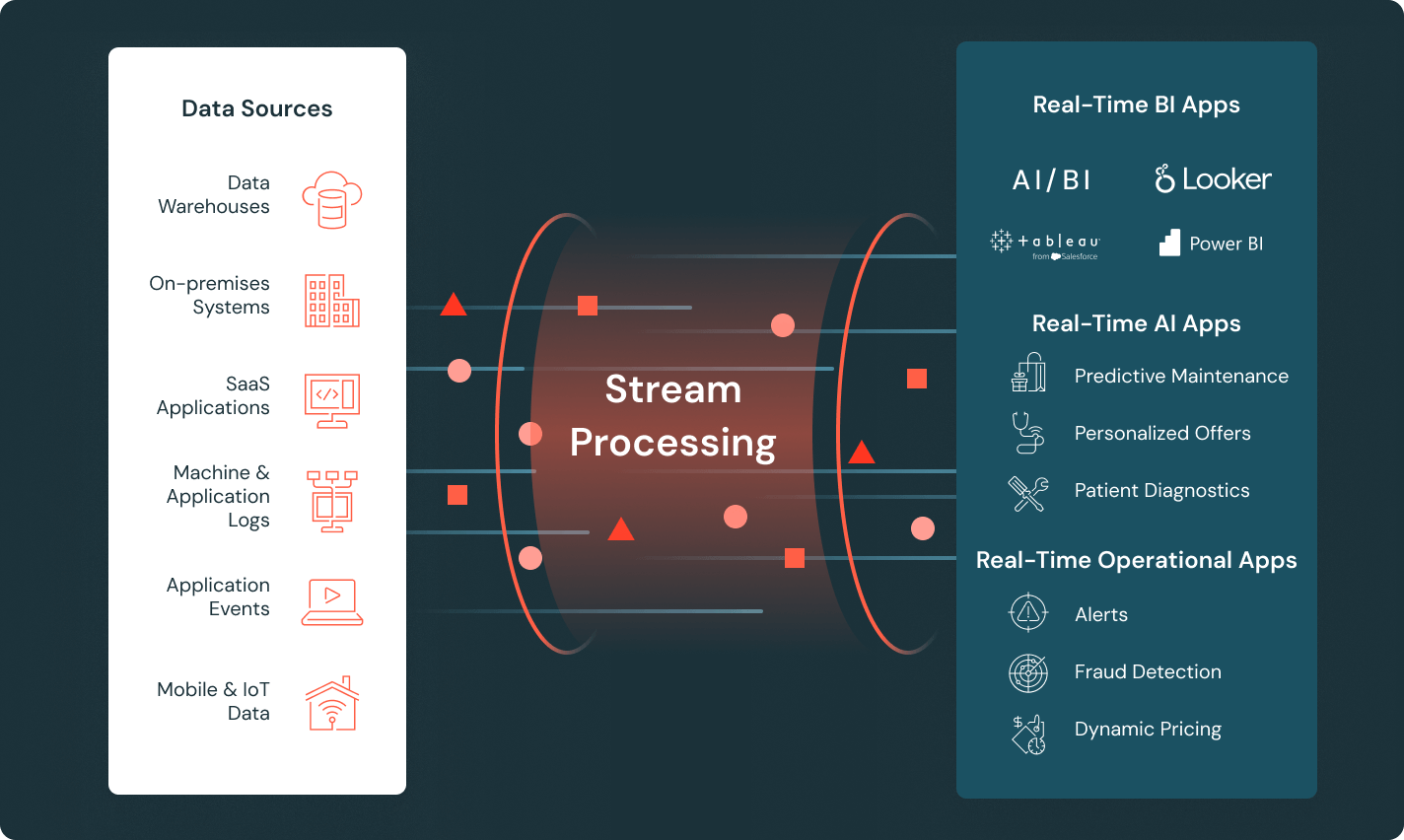

Liefern Sie aktuelle Daten für Echtzeit-Einblicke

Erstellen Sie Pipelines, die in Echtzeit Daten von Sensoren, Clickstreams und IoT-Geräten verarbeiten und direkt in Echtzeit-Anwendungen einspeisen. Reduzieren Sie die betriebliche Komplexität mit Lakeflow Declarative Pipelines und verwenden Sie Streaming-Tabellen für eine einfachere Pipeline-Entwicklung.

Orchestrieren Sie komplexe Workflows mit Leichtigkeit

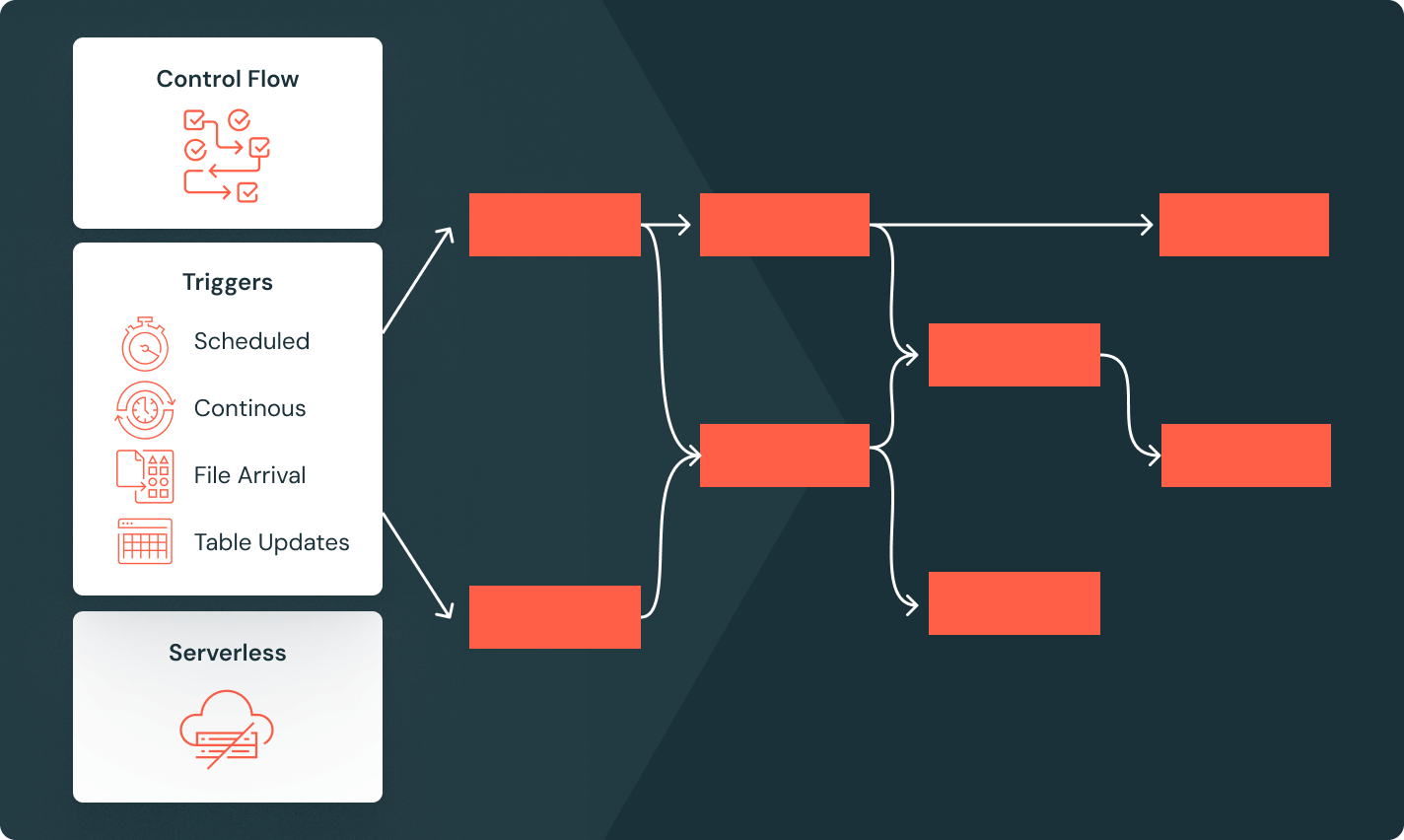

Definieren Sie zuverlässige Analyse- und KI-Workflows mit einem verwalteten Orchestrator, der in Ihre Datenplattform integriert ist. Implementieren Sie komplexe DAGs einfach mit erweiterten Steuerungsflussfunktionen wie bedingter Ausführung, Schleifen und einer Vielzahl von Triggern für Jobs.

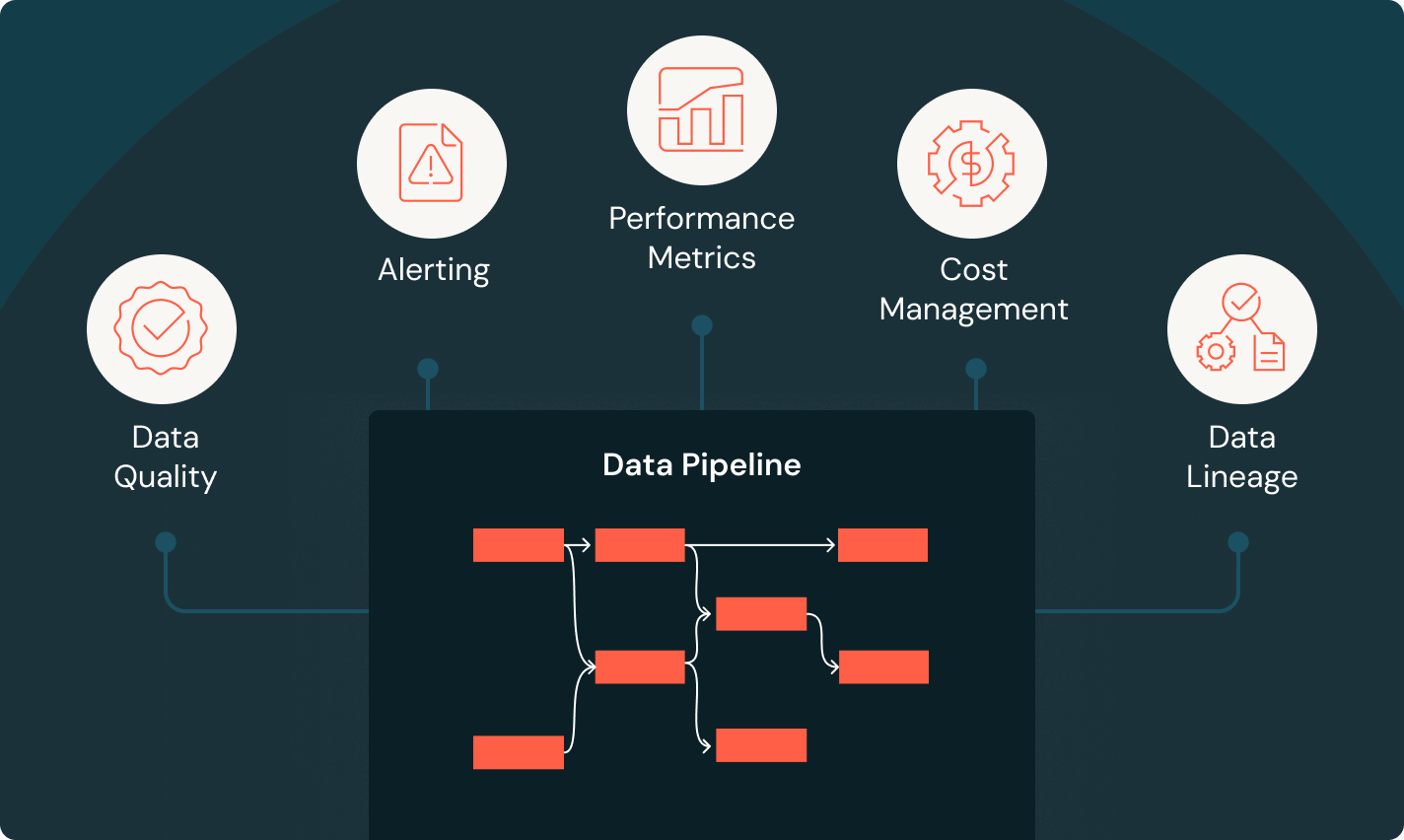

Überwachen Sie jeden Schritt jeder Pipeline

Erhalten Sie volle Transparent über den Zustand Ihrer Pipelines – mit umfassenden Metriken in Echtzeit. Benutzerdefinierte Warnungen sorgen dafür, dass Sie genau wissen, wann Probleme auftreten, und detaillierte Visualisierungen zeigen die Ursache von Fehlern, damit Sie diese schnell beheben können. Wenn Sie Zugang zu End-to-End-Monitoring haben, behalten Sie die Kontrolle über Ihre Daten und Ihre Pipelines.

Wagen Sie den nächsten Schritt

FAQ zur Datenverarbeitung

Möchten Sie ein Daten- und KI-Unternehmen werden?

Machen Sie die ersten Schritte Ihrer Datentransformation